Robots.txt چیست تا به حال راجب Robots.txt چیزی شنیده اید؟ از اهمیت آن چطور اطلاع دارید؟

میدونید چگونه می توانید یک فایل Robots.txt ربات تکست را برای وب سایت خود ایجاد کنید؟ میدونید نحوه استفاده از Robots.txt به چه صورت است؟

می دونستید که برای سایت های وردپرسی هم می توانید از Robots.txt استفاده کنید؟ با نحوه ایجاد Robots.txt در سایت های وردپرسی آشنایی دارید؟

شاید هم جواب تمامی سوالات بالا را بدانید، اما نمی دونید چگونه می توانید فایل Robots.txt ربات تکست وب سایتتون رو مورد آزمایش قرار بدهید؟ ما قصد داریم تا در ادامه ی مقاله جوابی تمامی سوالات فوق را بدهیم، پس با ما همراه باشید.

همه چیز درباره ی Robots.txt

خوب بگذارید ابتدا یک تعریف خلاصه از Robots.txt به شما بدهیم.

Robots.txt میزان دسترسی موتور های جستجوگر نظیر گوگل را به وب سایت شما کنترل می کند.

در واقع Robots.txt یک فایل متنی درون دایرکتوری Root وب سایت شماست که در آن دستورالعمل هایی برای موتور های جستجوگر قرار گرفته است.

شما در این فایل متنی مشخص می کنید که موتور های جستجوگر به کدام یک از صفحات وب سایتتان اجازه دسترسی داشته باشند، یا به کدام یک از صفحات وب سایت شما اجازه دسترسی نداشته باشند.

شاید از خودتون بپرسید که مگر می شود وب سایتی نخواهد اجازه دسترسی صفحه ای از وب سایتش را به موتور های جستجوگر بدهد؟

همانطور که می دانید تمامی وب سایت ها علاقه دارند تا بیش تر مورد توجه موتور های جستجوگر قرار بگیرند و ترافیک سایتشان را بالا ببرند.

حال برخی از وب سایت ها ممکن است به دلیل داشتن اطلاعات خاص و یا مهم درون یک صفحه وب سایتشان نخواهند که موتور های جستجوگر به آن صفحه خاص دسترسی داشته باشند.

اینجاست که نقش فایل Robots.txt پررنگ می شود.

اگر می خواهید بدانید که درون رایرکتوری Root وب سایت خود فایل Robots.txt ربات تکست وجود دارد یا نه، تنها کافیست به انتهای نام دامنه وب سایت خود Robots.txt اضافه کنید و نتیجه را ببینید.

به طور مثال اگر دامنه وب سایت شما www.example.com باشد. اگر فایل Robots.txt در دایرکتوری Root وب سایت شما موجود باشد. شما می توانید با وارد کردن آدرس https://www.example.com/robots.txt در مرورگر کامپیوترتان، فایل Robots.txt وب سایتتون را مشاهده کنید، و پس از وارد کردن آن با چنین چیزی روبرو میشوید:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

sitemap: https://aranikweb.ir/sitemap_index.xml

نحوه استفاده از Robots.txt چگونه است؟

برای اینکه بخواهیم از نحوه استفاده از Robots.txt به شما بگوییم، ابتدا شما باید با هر کدام از اجزای فایل Robots.txt آشنایی پیدا کنید.

اولین نوشته ای که در فایل Robots.txt با آن برخورد می کنید، User-agent است.

همانطور که می دانید، موتور های جستجوگر به واسطه ی روبات هایی، صفحه ی وب سایت شما را آنالیز می کنند، و هر کدام از موتور های جستجوگر روبات مخصوص به خود را دارا می باشند.

در قسمت User-agent، شما باید نام روبات موتور جستجوگری که شما نمی خواهید آن روبات صفحه وب سایت شما را آنالیز کنید، را بیاورید.

حال پس از آنکه اسم روبات موتور جستجوگر را درون فایل Robots.txt قرار دادید.

باید در قسمت Disallow، آدرس صفحه ای از وب سایتتان که نمی خواهید ربات موتور جستجوگر به آن دسترسی داشته باشد را بیاورید.

در قسمت Allow هم شما می توانید زیر پوشه ای از صفحه وب سایت انتخابیتان را از این قاعده مستثنی کنید و به روبات های موتور های جستجوگر اجازه دسترسی به آن را بدهید.

آخرین نوشته ای که باید درون فایل Robots.txt ربات تکست وب سایتتان قرار بگیرد، آدرس sitemap وب سایتتان است. اما خوب شاید برای شما سوال شود که چرا باید نقشه سایتتان را در فایل Robots.txt قرار دهید؟

در جواب باید به شما بگویم که شما با قرار دادن نقشه سایتتان درون این فایل، نقشه وب سایتتان را در اختیار روبات های موتور های جستجو قرار می دهید، تا آن ها راحت تر بتوانند وب سایت شما را آنالیز کنند.

یک مورد دیگر که ممکن است در فایل Robots.txt بالا نظر شما را به خود جلب کند، علامت ستاره است.

علامت ستاره به این مفهوم است که شما تمامی روبات های موتور های جستجوگر را انتخاب کرده اید.

حال در ادامه با نشان دادن مثال هایی به شما قصد داریم تا نحوه استفاده از این دستور ها را بیش تر برای شما توضیح بدهیم:

مثال اول: در مثال اول ما می خواهیم به شما نشان دهیم، چگونه می توانید کل سایتتان را از دسترس روبات های موتور های جستجوگر مخفی کنید.

برای اینکار کافی است دستور زیر را در فایل Robots.txt وب سایتتان قرار دهید.

User-agent: *

Disallow: /

مثال دوم: در مثال دوم ما می خواهیم اجازه دسترسی تمامی صفحات وب سایتمان را به روبات های موتور های جستجوگر درون فایل Robots.txt را بدهیم.

برای اینکار کافی است که دستور زیر را به فایل Robots.txt وب سایتتان اضافه کنید.

User-agent: *Disallow:

مثال سوم: فرض کنید شما می خواهید پوشه ی /cgi-bin/ را از دسترسی روبات های موتور های جستجوگر مخفی کنید یا اینکه صفحه ای خاص از وب سایتتان را از دسترسی روبات ها مخفی کنید.

شما کافی است که دستورات زیر را در فایل Robots.txt وب سایتتون وارد کنید:

User-agent: *

Disallow: /cgi-bin/

User-agent: *

Disallow: /page_url

مثال چهارم: ما تا کنون به شما نشان دادیم که چگونه می توانید اجازه دسترسی صفحه ای از وب سایتتان را از تمامی روبات های موتور های جستجوگر بگیرید.

اما اگر شما بخواهید روبات یک موتور جستجوگر خاص را انتخاب کنید و اجازه دسترسی صفحه وب سایتتان به آن روبات خاص را ندهید باید دستورالعمل زیر را درون فایل Robots.txt وب سایتتان وارد کنید.

به طور مثال ما در دستور العمل پایین، روبات موتور جستجوگر گوگل را انتخاب کرده ایم:

User-agent: Googlebot

Disallow: /docs/

مثال پنجم: حالا فرض کنید ما می خواهیم اجازه دسترسی یک عکس خاص در فولدر docs وب سایتمان را به روبات موتور جستجوگر گوگل بدهیم.

دستوری که در فایل Robots.txt باید قرار دهیم، تقریبا شبیه به دستور بالا است. تنها تفاوت آن این است که باید Allow را به مجموعه دستور بالا اضافه کنیم.

User-agent: Googlebot

Allow: /docs/file.jpeg

Disallow: /docs/

اهمیت فایل Robots.txt چیست ؟

1- با استفاده از فایل Robots.txt از فراگیر شدن اطلاعات مهم وب سایتتون جلوگیری می کنید.

یکی از کاربرد های فایل Robots.txt این است که شما می توانید از دسترسی روبات های موتور های جستجوگر به اطلاعات مهم وب سایتتان جلوگیری کنید.

به طور مثال شما می توانید صفحات وروی کاربران به صفحه وب سایتتان(Login Pages) ، قسمت هایی از وب سایتتان که در حوزه کاری ادمین های وب سایتتان است و اطلاعات شخصی کاربران وب سایتتان را از دسترس روبات های موتور های جستجوگر خارج کنید.

خارج کردن چنین اطلاعاتی به واسطه فایل Robots.txt می تواند ضریب امنیت وب سایتتان را بالا ببرد و وب سایت شما را به وب سایتی امن تبدیل کند.

برخی از صفحات و پوشه هایی که پیشنهاد می شود آن ها را در فایل Robots.txt وب سایتتون قرار دهید شامل موارد زیر می شود:

- /cart/

- /cgi-bin/

- /scripts/

- /wp-admin/

2- با استفاده از فایل Robots.txt می توانید صفحات بی کیفیت از وب سایتتان را مخفی کنید.

بسیاری از وب سایت ها نمی خواهند که صفحات بی کیفیت از وب سایتشان توسط روبات های موتور های جستجوگر مورد بررسی قرار بگیرد.

موتور های جستجوگر نیز مانند گوگل بار ها و بار ها به صاحبان وب سایت ها یادآور می شوند که صفحات بی کیفیت از وب سایتتان را از روی وب سایتتان حذف کنید.

قطعا قرار دادن این چنین صفحات درون فایل Robots.txt می تواند در بهبود کیفیت وب سایتتان موثر باشد.

3- صفحاتی از وب سایتتان که حاوی محتوای تکراری هستند را می توانید در Robots.txt قرار دهید.

برخی از وب سایت ها به دلیل کسب و کاری که مشغول به آن هستند. ناچار به استفاده از محتوای تکراری درون صفحات وب سایتشان هستند.

قطعا قرار دادن محتوای تکراری در صفحات وب سایتتان می تواند صدمه جبران ناپذیری بر روی رتبه ی وب سایتشان در موتور های جستجوگر داشته باشد. چرا که موتور های جستجو گر از محتوای تکراری متنفرند.

خوب بهترین کار برای صاحبان چنین وب سایت هایی این است که صفحاتی از وب سایتشان که حاوی محتوای تکراری است را درون فایل Robots.txt قرار دهند.

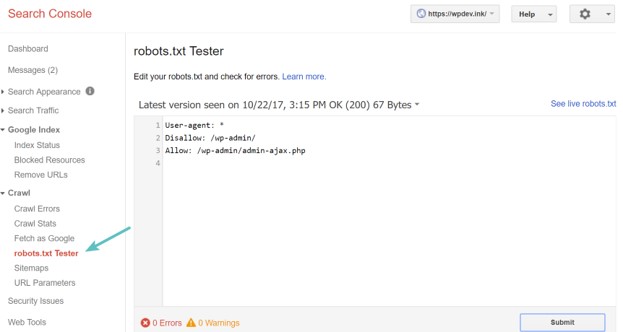

چگونه می توانیم فایل Robots.txt وب سایتمان را تست کنیم

یکی از معضلاتی که امروزه صاحبان وب سایت ها با آن دست و پنجه نرم می کنند. قرار گرفتن صحیح دستورالعمل ها درون فایل Robots.txt وب سایتشان است. چرا که اگر درون چنین فایلی شما یکی از حروف را به اشتباه قرار دهید، یا یک خط فاصله اشتباه بگذارید.

یا حتی در قرار دادن حروف بزرگ و کوچک درون این فایل اشتباه کنید. می تواند به دسترسی صفحات وب سایتتان به روبات های موتور های جستجوگر بیانجامد. خوشبختانه ابزار های مختلفی در اینترنت وجود دارد که شما می توانید به کمک آن فایل Robots.txt وب سایتتان را تست کنید و از درستی دستور العمل های موجود در آن اطمینان حاصل کنید.

یکی از این ابزار ها، ابزار search console گوگل است، که شما به راحتی و به صورت رایگان می توانید فایل Robots.txt وب سایتتان را در آن بسنجید.

برای اینکار کافی است وارد search console گوگل شوید و در منوی سمت چپ بر روی Crawl کلیک کنید. پس از کلیک می توانید گزینه Robots.txt Tester را ببینید.

پس از آن باید دستور العملی را که می خواهید در فایل Robots.txt وب سایتتان وارد کنید را درون پنجره paste کنید، و در ادامه بر روی گزینه submit کلیک کنید.

همانطور که در تصویر بالا مشاهده می کنید. (در انتهای صفحه) قسمتی در زیر پنجره Test فایل Robots.txt وجود دارد که شامل Error ها و هشدار ها است.

شما می توانید تمامی اشتباهاتی که ممکن است در حین نوشتن دستورالعمل ها مرتکب شده اید را ببینید و تا آنجایی که می توانید آن ها را رفع کنید.

در تصویر بالا کنسول سرچ گوگل نتوانست در دستورالعمل فایل Robots.txt ما اشکالی را یافت کند. این به این معناست که ما دستورالعمل فایل Robots.txt وب سایتمان را به درستی نوشته ایم.

آیا Robots.txt برای سایت های وردپرسی هم وجود دارد؟

در جواب این سوال باید بگویم که Robots.txt برای سایت های وردپرسی هم وجود دارد و شما می توانید با استفاده از FTP یا فایل منیجر آن را ایجاد کنید.

همچنین همانطور که می دانید اضافه کردن افزونه های مختلف یک ویژگی عالی برای وردپرس به شمار می آید.

شما می توانید با اضافه کردن افزونه هایی و به کمک آن ها فایل Robots.txt وب سایتتان را ایجاد و یا در آن تغییراتی را اعمال کنید. در ادامه مقاله ما نحوه ایجاد فایل Robots.txt را با استفاده از افزونه ها و FTP به شما نشان می دهیم.

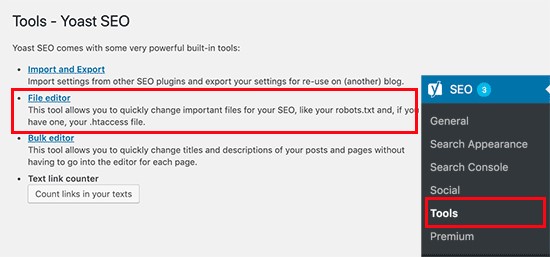

1- نحوه ایجاد و تغییر در Robots.txt با استفاده از افزونه Yoast seo

خوب اولین کاری که باید انجام دهید. دانلود این افزونه و اضافه کردن آن به وردپرستان است.

شما می توانید با استفاده از این لینک https://wordpress.org/plugins/wordpress-seo/ این افزونه را دانلود کنید. پس از دانلود به قسمت Tools این افزونه بروید و بر روی File editor کلیک کنید

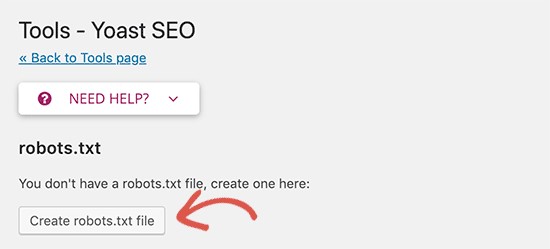

پس از کلیک بر روی File editor، پنجره ای جدید به شما نمایش داده می شود که نشان می دهد که آیا سایت وردپرسی شما Robots.txt را دارد یا ندارد. در مثال عکس پایین، سایت وردپرسی ما فایل Robots.txt را ندارد. به همین علت برروی گزینه Creat Robots.txt کلیک می کنیم

خود این افزونه به صورت پیش فرض یک فایل Robots.txt برای وب سایت شما می سازد. دستورالعملی که در این فایل قرار گرفته است به این صورت است:

|

1 2 |

User-agent: * Disallow: / |

باید دقت کنید که چنین دستوری برای وب سایت وردپرسی شما مناسب نیست، چرا که اجازه دسترسی تمامی مطالب سایت شما به روبات های موتور های جستجوگر گرفته شده است.

برای همین خودتان با توجه به مطالبی که در اول این مقاله ذکر کردیم، می توانید در فایل Robots.txt وب سایتتان تغییر ایجاد کنید.

نکته ای که حتما باید به آن توجه کنید این است که با هر تغییری در این فایل، تغییرات را سیو کنید. و بر روی گزینه Save robots.txt file کلیک کنید.

2- نحوه ایجاد، تغییر و ادیت Robots.txt به واسطه FTP

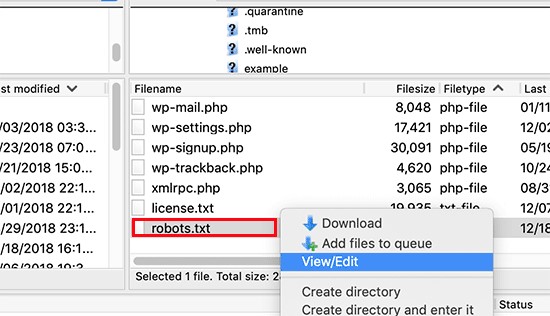

برای اینکار کافی است که از FTP Client استفاده کنید و به هاستینگ سایت وردپرسی خود وارد شوید. در ادامه شما در دایرکتوری Root وب سایتتان می توانید فایل هایی که وجود دارد را مشاهده کنید.

اگر فایل Robots.txt در وب سایتتون وجود داشته باشد، کافی است با یک راست کلیک بر روی گزینه view and edit کلیک کنید. و در آن تغییرات دلخواهتان را ایجاد کنید.

اگر هم فایل Robots.txt در دایرکتوری Root وب سایت شما موجود نبود، دوباره راست کلیک کرده و این بار بر روی گزینه creat new file کلیک کنید و فایل Robots.txt وب سایتتان را ایجاد کنید.

البته ایجاد این فایل با استفاده از افزونه، قطعا برای سایت های وردپرسی آسان تر است.

جهت مشاوره رایگان با ما تماس بگیرید:

۰۲۱-۲۸۴۲۸۶۷۶ برای تماس مستقیم

۰۹۰۳۸۴۸۱۰۱۲ (فقط چت واتس اپ)

ایمیل: info@aranikweb.ir